引言

在人工智能(AI)的世界中,“大模型微调”已经成为一个重要的术语。随着AI模型变得越来越复杂和强大,如何有效地利用这些模型来满足特定的需求变得至关重要。大模型微调技术提供了这样一种可能:在不从头开始训练模型的情况下,通过对预训练模型进行调整,使其能够更好地执行特定任务。这篇文章将揭示大模型微调的五个关键真相,帮助您深入了解这项技术及其潜力。

真相一:大模型微调的基本原理

定义与原理

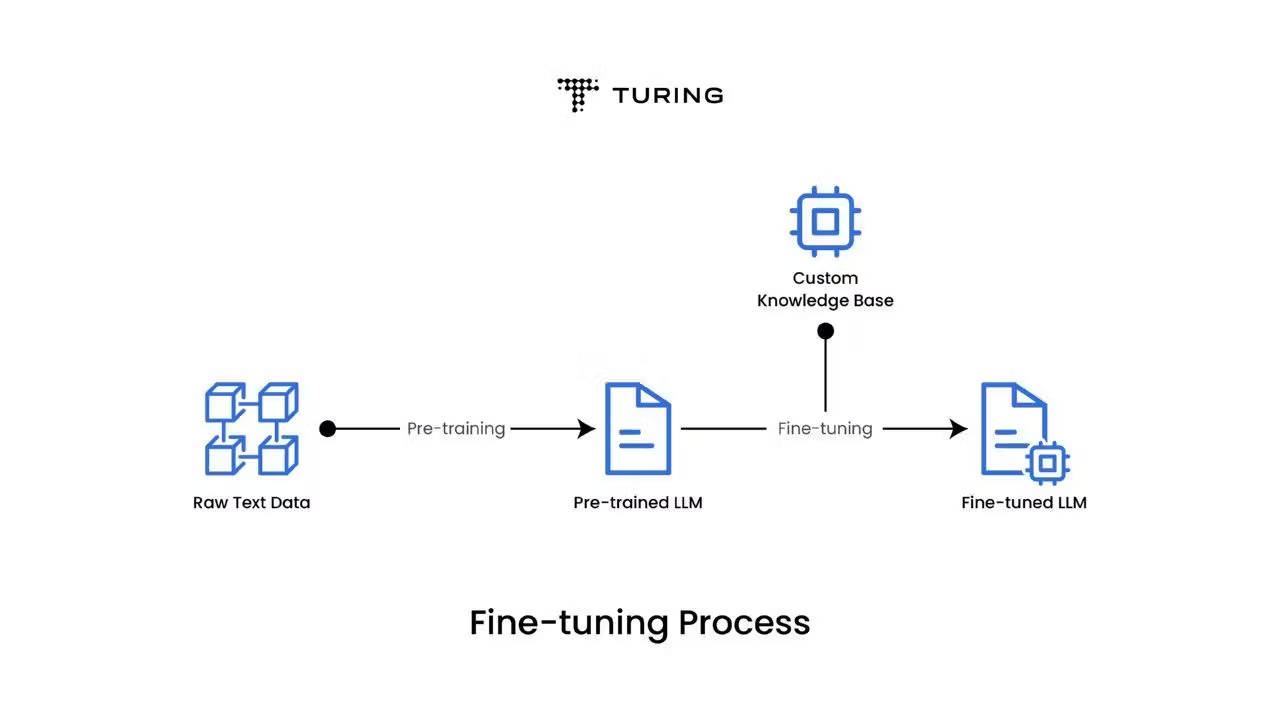

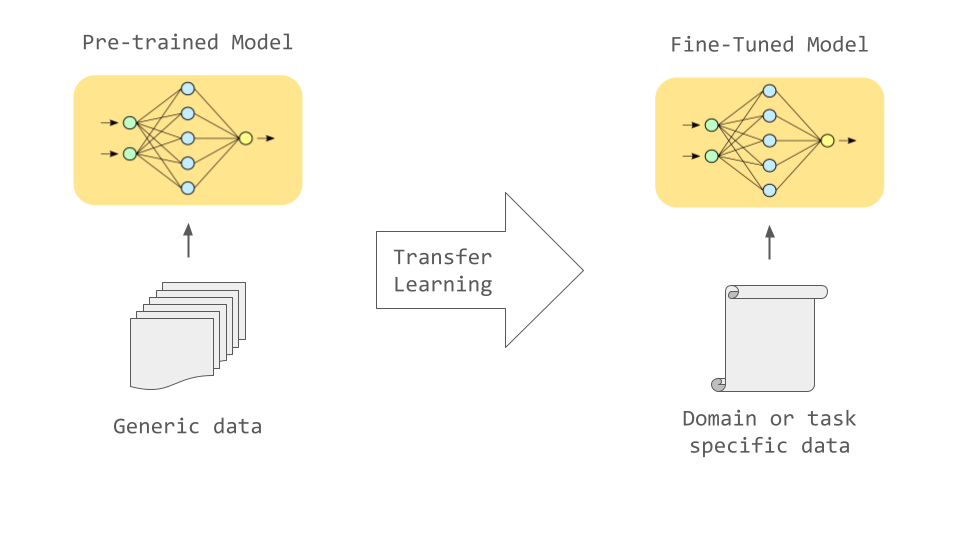

大模型微调(Fine-Tuning)是指在一个已经预训练好的大规模模型基础上,针对特定任务对模型参数进行进一步调整的过程。这通常涉及调整模型的少量参数,以提高其在特定任务上的性能,而不需要重新训练整个模型。

过程

微调过程通常包括以下几个步骤:

-

选择预训练模型:从公共资源中选择一个适合的预训练模型。

-

准备数据集:收集和准备与目标任务相关的数据集。

-

设置微调参数:根据任务的复杂性,设定学习率、优化器等超参数。

-

执行微调:通过调整模型的部分参数,使其适应特定任务。

-

评估与优化:在验证集上评估模型性能,并根据结果进行进一步的优化。

实际应用

大模型微调已经广泛应用于多个领域,如自然语言处理、计算机视觉和语音识别等。例如,在自然语言处理中,预训练的BERT模型通过微调可以用于文本分类、情感分析和问答系统等任务。

真相二:大模型微调带来的效益

精确性

通过微调,模型的预测准确度显著提高。预训练模型通常在大规模数据集上进行训练,因此具备很强的通用性,而微调则通过特定数据集的调整,使模型在特定任务上表现更加精准。

灵活性

微调赋予模型适应不同任务的能力。这意味着一个预训练模型可以在多个不同领域和任务上快速调整并应用,而无需从零开始训练新模型。

效率

微调显著减少了训练时间和计算资源。与从头训练一个大型模型相比,微调仅需对少部分参数进行调整,因此需要的计算资源和时间成本都大幅降低。

真相三:大模型微调的挑战

数据需求

成功的微调依赖于高质量的数据。缺乏足够多的相关数据可能导致模型无法充分学习特定任务的特征,影响微调效果。

计算资源

尽管微调比从头训练节省资源,但对于一些超大型模型,仍然需要高性能的计算资源,如GPU或TPU,以支持微调过程。

风险管理

在微调过程中,存在过拟合和模型偏见的风险。过拟合可能导致模型在训练数据上表现良好,但在新数据上效果欠佳;而偏见问题可能导致模型在某些群体或场景中表现不公正。

真相四:大模型微调的未来趋势

技术创新

随着技术的发展,微调方法也在不断创新。例如,近年来的适应性微调技术使得微调过程更加灵活和高效,能够更好地适应动态变化的任务需求。

应用前景

微调技术在新兴领域中的潜力巨大。无论是智能助理、自动驾驶还是个性化推荐系统,微调都可以帮助这些技术更好地满足个性化需求。

行业影响

大模型微调在AI行业中的影响将是深远的。通过提高AI模型的适应能力和性能,微调技术将推动整个行业的创新和发展,带来更智能和高效的解决方案。

真相五:如何开始大模型微调

实践指南

以下是大模型微调的一般步骤和技巧:

-

选择合适的预训练模型:根据任务选择适合的模型架构,如BERT、GPT或ResNet等。

-

优化超参数:调整学习率、批量大小等参数,以达到最佳微调效果。

-

持续监控:在微调过程中,定期评估模型性能,及时进行参数调整。

工具推荐

目前,市面上有多种工具和平台可以支持大模型微调,如TensorFlow、PyTorch和Hugging Face等。这些工具提供了丰富的预训练模型和微调功能,便于快速实现微调。

专家建议

为了成功微调,专家建议:

-

选择具有代表性的数据集,以确保模型能够有效学习任务特征。

-

控制模型复杂度,避免过拟合。

-

定期更新和评估模型,确保其持续满足业务需求。

结论

通过揭示大模型微调的五个真相,我们可以更全面地理解这项技术的重要性及其广泛应用。在未来,大模型微调将继续在AI领域发挥关键作用,推动技术进步和创新。我们鼓励读者进一步探索和实践微调技术,以便在各自的领域中实现更大的突破和成就。

这篇文章详细介绍了大模型微调的基本概念、优势、挑战以及未来趋势,为读者提供了一个深入理解大模型微调的框架。希望这篇文章能帮助读者更好地把握微调技术的应用与发展。