C-Eval

工具介绍:C-Eval是一个由顶尖大学研发的中文大语言模型评估套件,涵盖52个学科和4个难度级别,通过13,948个多项选择题全面测试AI的中文理解能力。

收录时间:2024-06-09 12:34:56

C-Eval 工具信息

目录

C-Eval:全面评估大语言模型中文能力的创新工具

C-Eval是一款专为评估大语言模型(LLMs)中文理解能力而设计的综合评测套件。这个创新性的工具由上海交通大学、清华大学和爱丁堡大学的研究团队于2023年5月联合推出。

C-Eval的主要特点包括:

- 包含13,948个多项选择题

- 涵盖52个不同学科领域

- 设有四个难度级别

通过这种多层次、多学科的评估方法,C-Eval能够全面且深入地测试大语言模型在中文理解和应用方面的能力,为研究人员和开发者提供了宝贵的评估工具。

C-Eval 替代品

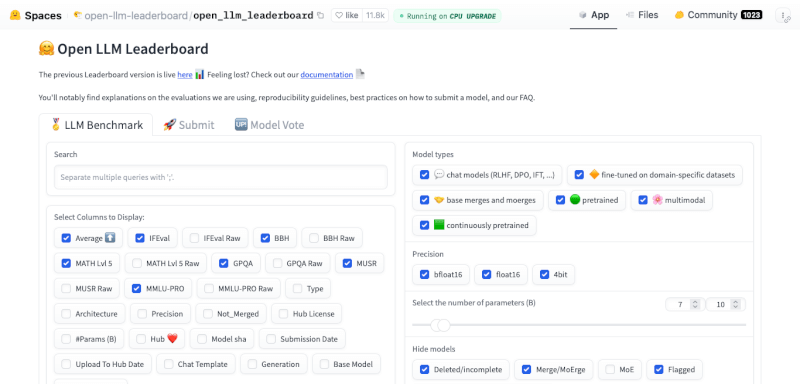

Open LLM Leaderboard

探索HuggingFace的Open LLM Leaderboard,一个用于评估开源大型语言模型性能的平台。了解其采用的四大关键基准测试,包括AI2推理挑战、HellaSwag、MMLU和Tr...

FlagEval

FlagEval(天秤)是智源研究院开发的全面大模型评测平台,采用三维评测框架,提供30多种能力、5种任务和4大类指标的评测,涵盖600多个维度,包含84,433道题目,旨在全面评估大模型性能。

评论 (0)

暂无评论